تقریباً یک ماه پس از معرفی فناوری DALL-E 2 جدیدترین سیستم هوش مصنوعی OpenAI برای ساختن تصاویر از روی متن، گوگل سیستم تبدیل متن به عکس خودش با عنوان Imagen را معرفی کرد.

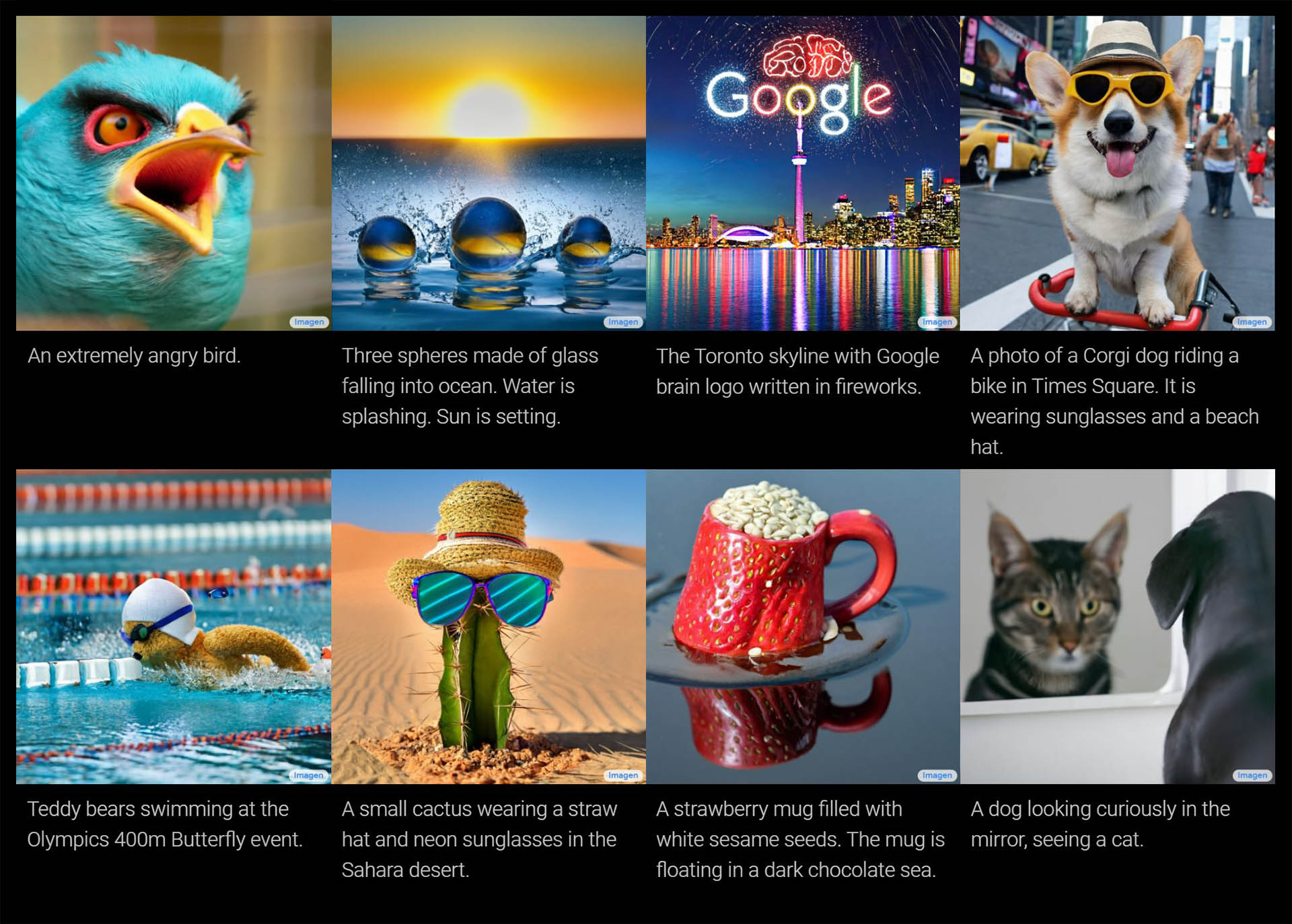

نتایج سیستم جدید جالب توجه هستند. Imagen با گرفتن یک ورودی متنی مثلاً «یک سگ که کلاه آبی و لباس قرمز پوشیده» کار خود را شروع میکند و سپس رمزگذار T5-XXL آن متن ورودی را تبدیل به توابع ریاضیاتی میکند. سپس این توابع به یک عکس کوچک ۶۴ در ۶۴ پیکسلی تبدیل میشوند. Imagen این عکس کوچک را به یک عکس ۲۵۶ در ۲۵۶ پیکسلی و ۱۰۲۴ در ۱۰۲۴ پیکسلی تبدیل میکند.

بهعنوان مثال، تصویر زیر که از متن «a cute corgi lives in a house made out of sushi» (یک سگ نژاد کورگی که زیر خانهی ساختهشده از سوشی زندگی میکند) را در نظر بگیرد. این تصویر بهشکل شگفتانگیزی واقعگرایانه و باورپذیر است، طوری که انگار واقعاً کسی یک خانه از سوشی برای آن سگ درست کرده است.

این یک عکس بامزه است. در واقع، انگار تمامی آنچه تاکنون از Imagen دیدهایم بامزه هستند: حیوانات پشمالو در لباسهای خندهدار، کاکتوسی با عینک آفتابی، شنای خرس عروسکی، راکونهای سلطنتی و غیره. پس آدمها کجایند؟

مسلماً افراد زیادی هستند که متنهایی با مضمون حیوانات بامزه در موقعیتهای خندهدار وارد میکنند، اما همچنین باید متنهایی دربارهی سرآشپزها، ورزشکاران، مردان، زنان و کودکان نیز وجود داشته باشد. این افراد چه شکلی خواهند بود؟ آیا بیشتر دکترها مرد میشوند، بیشتر پرستاران زن میشوند، یا بیشتر آدمها سفیدپوست؟

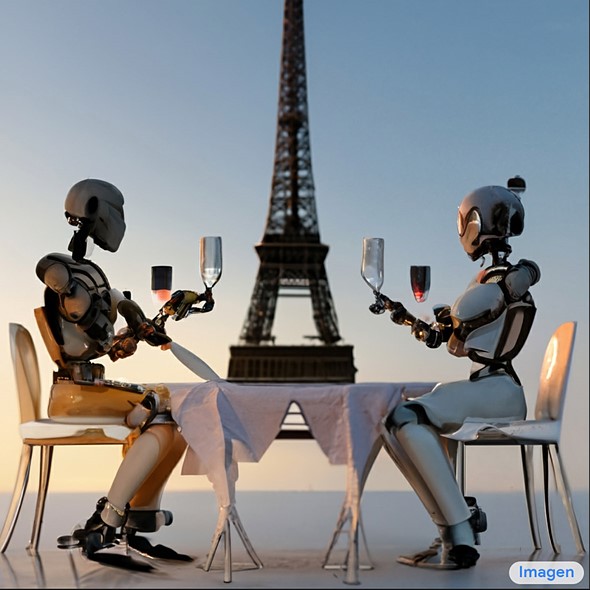

نتیجهی این عکس چه شکلی میشد اگر واژه «ربات» در این متن قرار نداشت؟

ما نمیدانیم که Imagen چطور از پس این گونه متنها برمیآید چرا که گوگل ترجیح داده فعلاً هیچ انسانی را نشان ندهد. چالشهایی اخلاقی در زمینهی تبدیل متن به عکس وجود دارد. اگر یک سیستم میتواند هر تصویری از یک متن بسازد، چنین سیستمی در ارائهی نتایج غیرکلیشهای و بدونتبعیض تا چه حد موفق خواهد بود؟

فناوریهای هوش مصنوعی مثل Imagen عمدتاً با استفاده از دادههای جمعآوریشده از فضای وب شیوهی کار خود را میآموزند. محتوای موجود در اینترنت خاصیتی مغرضانه دارد که هنوز در تلاش برای درک آن هستیم. علاوه بر این، گوگل برای Imagen از مجموعهدادهی LAION-400M استفاده میکند که گفته میشود «حاوی گسترهی بزرگی از محتواهای نامناسب از جمله پرنوگرافی، توهینهای نژادپرستانه و کلیشههای اجتماعی مخرب است.» با وجود تلاشهایی برای حذف محتوای «نامناسب»، همچنان «این خطر وجود دارد که Imagen کلیشهها و بازنماییهای مخربی را تولید کند، که باعث شده این تصمیم را بگیریم که Imagen را بدون تدابیر امنیتی بیشتر برای استفادهی عمومی منتشر نکنیم.»

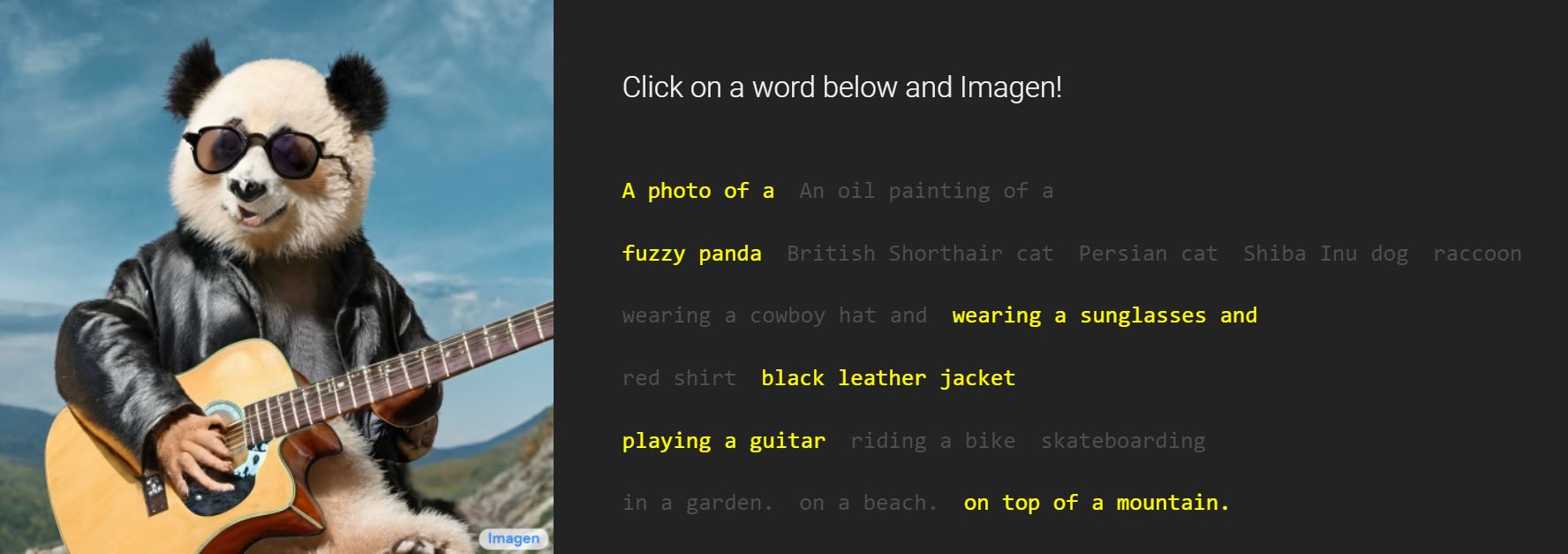

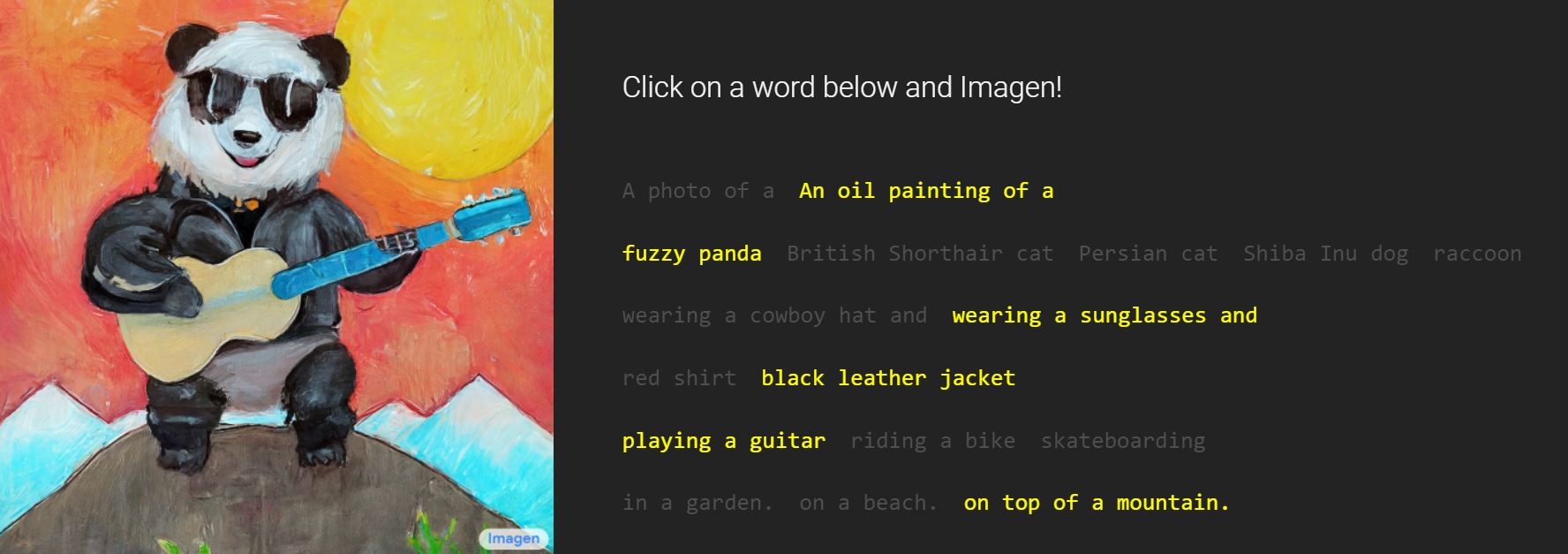

بنابراین، شما نمیتوانید آزادانه به Imagen دسترسی داشته باشید. در این وبسایت، گوگل صرفاً اجازه کلیک کردن روی واژههای خاصی را به شما میدهد. شما امکان این را ندارید هیچ متنی در رابطه با انسانها یا هر عمل و چیز مسألهسازی وارد کنید. اما اگر بتوانید، متوجه خواهید شد که این سیستم بیشتر تمایل به این خواهد داشت که تصاویری از افراد با رنگ پوست روشنتر تولید کند و نقشهای سنتی جنسیتی را نشان دهد.

متنهای ورودی میتوانند کاملاً پیچیده باشند.

البته شاید این تقصیر Imagen یا هر سیستم هوش مصنوعی دیگر نباشد. این سیستمها بر اساس مجموعهدادههای بزرگی کار میکنند که حاوی تبعیضها و کلیشههای عیان و پنهانی در خود هستند. علاوه بر تبعیض و به حاشیه بردن گروههای خاصی از مردم، این سیستمهای هوش مصنوعی همچنین میتوانند محتواهای بسیار مخربی تولید کنند. اگر از یک نقاش بخواهید که تصویر چیز وحشتناکی را بکشد، ممکن است خیلی از آنها از این کار خودداری کنند. اما سیستمهای هوش مصنوعی ندای وجدان و احساسات اخلاقی ندارند و میتوانند هر چیزی تولید کنند. این مسألهی مهمی است و معلوم نیست در آینده چگونه میتوان با آن روبهرو شد.

سایت خوب با مقالاتی بسیار بی نظیری دارین